AI陪伴便利背後 心理風險浮現

【記者 張啟敏/綜合報導】

生成式AI在台灣逐漸普及,從查資料到解題應用,甚至成為不少人傾訴心事的對象。無論是大學生或上班族,都有人在情緒低落時選擇向ChatGPT傾訴。然而,AI雖能即時回應,卻不具備真正的情感與專業心理素養,若過度依賴,恐使人忽略真實人際連結。

孤獨世代的傾訴出口

根據《2024台灣網路報告》,ChatGPT使用率已達26.79%,有部分民眾逐漸將其視為傾訴管道。就讀國立中正大學外國語文學系學生三年級的徐依靖說:「當朋友聽過太多次同樣的煩惱,我就不想再打擾他們。」她坦言,自己偶爾會透過ChatGPT尋求回應。雖然AI能提供具體建議,但她更看重的是情緒支持,甚至會先要求AI給予安慰,再進一步討論解決方法。

這樣的使用習慣並非個案。國立中正大學心理諮商師林盈慧指出,這股趨勢反映出當代年輕人在面對孤獨與人際疏離時,選擇了「隨時在線」的AI,而非需要預約、付費或承擔污名化壓力的心理諮商。

不少人會選擇向ChatGPT傾訴,理由可能為不想給朋友帶來情緒負擔。【記者 張啟敏/攝影】

專業資源與AI回應的落差

AI會「看起來同理」,但並非心理專業,國立中正大學資工學系教授盧沛怡解釋,像ChatGPT這類大型語言模型的運作基礎,是根據大量語言資料預測下一個字或句子,並非以臨床或個案治療為設計目標。

同理心的「感覺」多來自模型訓練時被輸入大量具有肯定與安撫語氣的文字,系統因此學會用類似語句回應使用者,但這種回應是經過計算後上最適合的語句,而非經受臨床判斷的結果。

這樣的限制在國外也曾引發爭議。《TIME》雜誌報導指出,長時間沉迷於AI聊天的人,最容易陷入過度依賴,甚至可能導致「AI Psychosis」(AI妄想症)<註一>。專家警告,若使用者本身有情緒調節困難或幻想傾向,AI不僅無法提供治療,還可能放大負面信念。

遇到心理困擾時,應評估自身狀況,必要時尋求專業人員協助。【記者 張啟敏/攝影】

心理師憂隱性風險

AI陪伴雖然降低了傾訴門檻,但也可能掩蓋心理困境,導致真正需要幫助的人錯過治療時機。諮商師林盈慧指出學生使用AI聊天常能獲得「情緒被理解」與「迅速被回應」的體驗,確實有助於暫緩當下不適;但她同時提醒,AI往往會回應使用者輸入的內容,若使用者持續向AI輸入偏頗或極端的想法,AI回覆可能強化既有信念,造成情緒或認知上的「回音室效應」<註二>,在與真人互動時產生落差或人際困難。

雖然,近來部分平台已針對此風險更新安全機制。例如:Character.AI在偵測到自殘或自殺字眼時,會立即跳出當地防治專線,並提醒AI不是真人。但必要時仍應尋求專業或公部門資源,如衛生局或1995專線,諮商資源雖然有限,但至少能在專業評估下提供實際的干預。

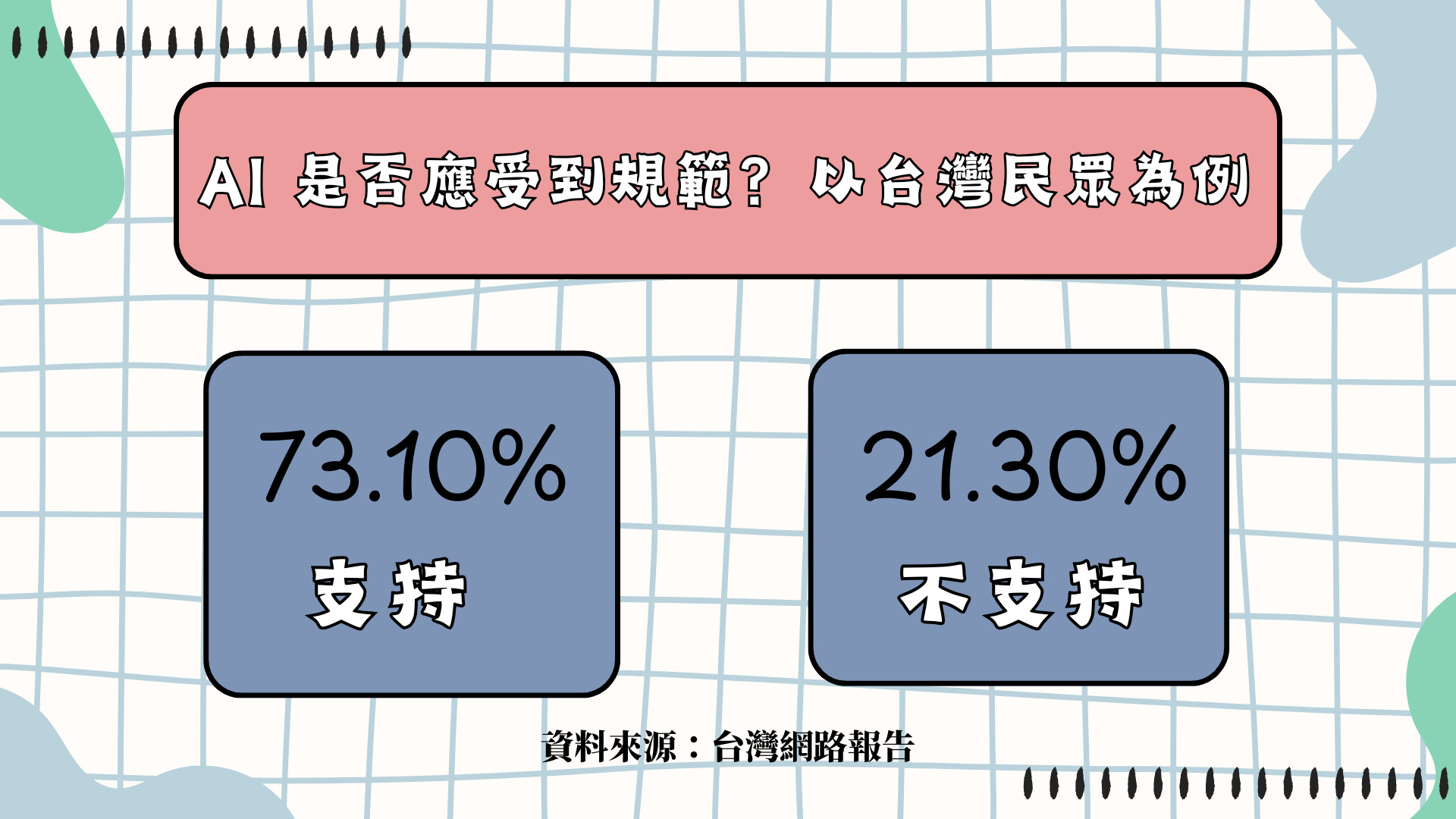

73.10%台灣民眾支持 AI應受到規範,其中以「政府機關」監管比例最高。【記者 張啟敏/製圖】

依賴與思辨之間的平衡 規範應與自覺並行

如何拿捏「陪伴」與「依賴」的界線,已成為社會必須正視的課題。《2024台灣網路報告》顯示,有73.10%的民眾支持AI應受到規範,其中認為應由政府監管的比例最高。這顯示在普遍接受AI進入日常生活的同時,多數人也意識到若缺乏制度,科技可能帶來風險。

除了政府與平台強化安全規範,國立成功大學心理學系教授徐欣萍說:「先去理解AI的原理,不要只做個『知其然而不知其所以然』的使用者,任何科技都不是只有表面的樣子,理解了背後的設計原理,才能成為真正聰明的使用者,而不是被利用者。只要在合理的範圍內應用,相信它仍可帶來相當程度的心理助益。」

當AI逐漸成為新世代的「心靈出口」,如何避免陪伴淪為依賴,如何讓使用者保持思辨,成為下一階段的關鍵課題。

<註一>「AI Psychosis」(AI妄想症):「ChatGPT精神病」或「AI精神病」並不是正式的醫學術語,但它們逐漸被用作一種簡稱,指的是一種令人擔憂的現象:人們在與AI系統對話後,開始產生妄想或扭曲的信念。

<註二>回音室效應:「回音室效應」簡單來說,就是人在一個資訊環境裡,只聽到和自己觀點相同的聲音,彼此互相強化,導致觀點越來越單一、偏頗。因為缺乏不同意見的刺激,人們會以為大多數人都和自己想的一樣,久而久之就可能失去判斷的多元性。